Yapay zekâ modelleri İnternet’in her köşesindeki geniş veri alanları üzerinde eğitiliyor, insanlar tarafından.

Sözleşmeli yapay zekâ değerlendiricileri sohbet robotlarını akıllı hale getirme işindeki zahmetli teslim tarihlerinden, düşük ücretlerden ve şeffaf olmayan çalışmalardan şikayetçiler.

İllüstrasyon: Rita Liu/The Guardian

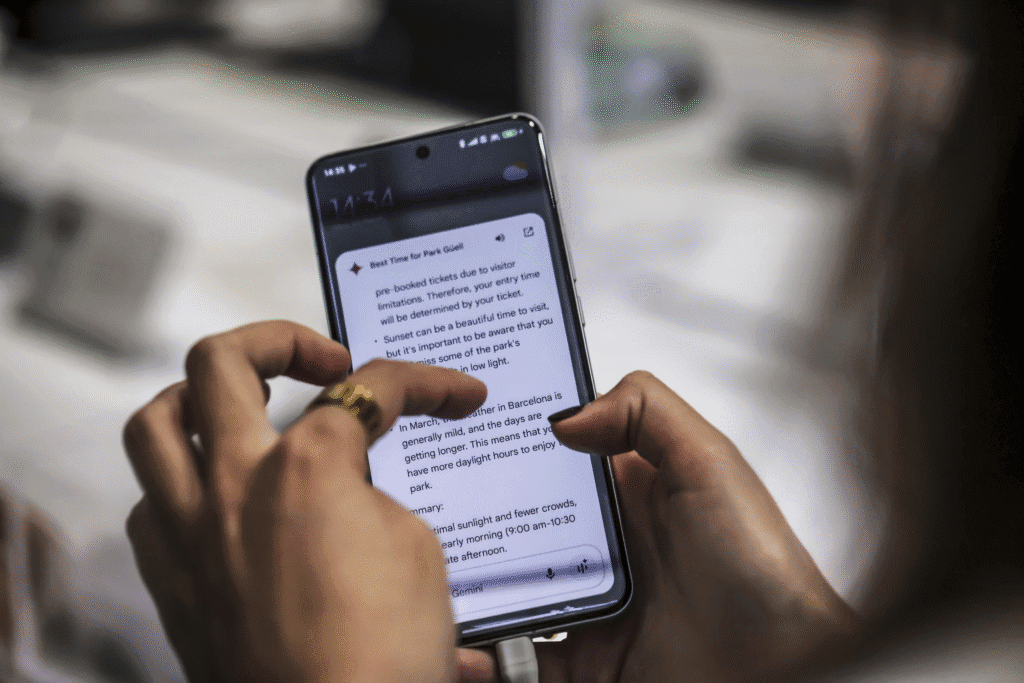

Teksaslı teknik yazar Rachael Sawyer 2024 yılının baharında LinkedIn üzerinden bir işe alım uzmanından yazı analisti gibi belirsiz bir pozisyonla ilgili bir mesaj aldığında, bunun önceden karşılaştığı içerik oluşturma işlerine benzediğini düşündü. Ancak bir hafta sonraki ilk iş gününde bu beklentisi suya düştü. Sawyer’in işi sözcükleri kendisinin yazması değildi, yapay zekâ tarafından üretilmiş içeriği derecelendirmek ve denetlemekti.

İş başlangıçta Google Gemini tarafından özetlenmiş toplantı notları ve sohbetleri incelemek ve bazı durumlarda yapay zekâ tarafından yapılmış kısa filmleri gözden geçirmek gibi çeşitli görevleri içeriyordu.

Bazen Gemini tarafından oluşturulmuş aşırı içerikle ilgilenmesi isteniyordu, çoğunlukla metin şeklindeki şiddet içeren ve müstehcen materyalleri kaldırılması için işaretliyordu. Zamanla, arada sırada bu tür metin ve görüntüleri denetlemekten, tamamen bu işle görevlendirilmeye başladı.

Sawyer, “işimin bu kadar rahatsız edici içeriklerle çalışmayı gerektirmesi beni şok etti” dedi. Mart 2024’ten beri Google’ın yapay zekâ ürünleri için “genel değerlendirici” olarak çalışıyor. “Salt işe başlarken bana uyarıda bulunulmadığı veya hiçbir onay formu imzalamam istenmediği için değil, aynı zamanda iş unvanında veya iş tanımında içerik denetiminden hiç söz edilmediği için de”.

Sawyer, her gün her biri 10 dakika içinde tamamlanması gereken düzinelerce görevi yerine getirme baskısıyla endişe ve panik atak sarmalına sürüklendiğini söylüyor. İşvereninden herhangi bir ruh sağlığı desteği de almıyor.

Sawyer, Japon holding Hitachi’nin GlobalLogic şirketi aracılığıyla Google için sözleşmeli çalıştırılan binlerce yapay zekâ işçisinden biri. Bu işçiler, geçen yılın başında piyasaya sürülen önde gelen sohbet robotu Gemini ve arama sonuçlarının özetleri olan AI Overviews dahil olmak üzere Google’ın yapay zekâ ürünlerinin çıktılarını değerlendirip denetliyor. The Guardian şirketin mevcut ve önceki işçilerinden onuyla konuştu. Google, yapay zekâ derecelendirme hizmetleri için, Accenture ve önceden Appen‘i de içeren şirketlerle sözleşme düzenliyor.

Google, geçtiğimiz yıl, OpenAI’nin ChatGPT’sine rakip olacak bir dizi ürün yayınlayarak yapay zekâ yarışına geri döndü. Yapay zekâ modellerinin performansını takip eden lider tablosu LMArena‘ya göre, Google’nin en gelişmiş akıl yürütme modeli Gemini 2.5 Pro’nun, OpenAI’nin O3’ünden daha iyi olduğu söyleniyor. Her yeni model sürümü, daha yüksek doğruluk vaadiyle birlikte geliyor. Bu, her sürüm için yapay zekâ değerlendiricilerinin, model yanıtlarının kullanıcı için güvenli olup olmadığını denetlemek için daha fazla çalıştığı anlamına geliyor. Binlerce insan bilgisini tıp, mimarlık ve astrofizik gibi çeşitli alanlarda doğru yanıtları öğrenmesi, hataları düzeltmesi ve zararlı çıktılardan uzak durması için sohbet robotlarının yararına sunuyor.

Yapay zekâyı eğitmek için kullanılan verileri etiketleyen işçilere büyük bir ilgi var. Bununla birlikte, Sawyer da dahil olmak üzere, gece gündüz yapay zekâ çıktılarını denetleyen, sohbet robotlarının milyarlarca kullanıcısının yalnızca güvenli ve uygun yanıtları görmesini sağlayan başka bir işçi bölüğü daha var.

Yapay zekâ modelleri İnternetin her köşesindeki geniş veri alanları üzerinde eğitiliyor. Sawyer gibi işçiler küresel yapay zekâ tedarik zincirinin tam orta tabakasındalar. Çoğunlukla yapay zekâ modelleri veya kendi kendine giden arabalar için verileri etiketleyen Nairobi ve Kenya‘daki veri etiketleyicilerden daha fazla ücret alırken, bu modelleri tasarlayan Mountain View’deki mühendislerden daha az ücret alıyorlar.

Bu denetim editörleri olmasa belki daha fazla halüsinasyon1çn. halüsinasyon basitçe üretken yapay zekânın kaynağı olmayan bilgileri üretip gerçekmiş gibi kullanıcılara sunması. Bkz. https://teyit.org/teyitpedia/teyit-sozluk-yapay-zeka-halusinasyonu-nedir görecek olan yapay zekâ modellerine yaptıkları bu önemli katkılara rağmen bu işçiler kendilerini görünmez hissediyorlar.

Almanya Bremen’deki Dağıtık Yapay Zekâ Araştırma Enstitüsü’nde bir araştırmacı olan Adio Diniko “yapay zekâ sihirli değil; insan emeğinden oluşan bir saadet zinciri” diyor. “Bu değerlendiriciler orta basamakta yer alıyorlar: görünmez, gerekli ve harcanabilirler”.

Google bir açıklamada şunu demişti: “Kalite değerlendiriciler tedarikçilerimiz tarafından istihdam ediliyor ve ürünlerimiz hakkında dışsal geri bildirim sağlamak üzere geçici olarak görevlendiriliyor. Derecelendirmeleri, sistemlerimizin ne kadar iyi çalıştığını ölçmemize yardımcı olan birleştirilmiş birçok veri noktasından biri olsa da algoritmalarımızı veya modellerimizi doğrudan etkilemiyor”. GlobalLogic bu haberimiz hakkında yorum yapmayı reddetti.

Yapay zekâ değerlendiricileri: gölge işgücü

Google, diğer teknoloji şirketleri gibi, veri işçilerini bir yükleniciler ve taşeronlar ağı aracılığıyla istihdam ediyor. Google’ın yapay zekâ değerlendiricileri için ana yüklenicilerinden biri GlobalLogic’tir. Bu değerlendiriciler iki geniş kategoriye ayrılıyor: genel değerlendiriciler ve süper değerlendiriciler. Süper değerlendiriciler içinde yüksek düzeyde uzmanlaşmış bilgiye sahip küçük insan grupları var. İlk başta bu roller için işe alınan işçilerin çoğu öğretmenlerdi. İşçilerin söylediğine göre işe alınanlar arasında yazarlar, güzel sanatlarda yüksek lisans derecesine sahip kişiler ve oldukça özel uzmanlığa sahip, örneğin fizikte doktora sahipleri var.

Görüşme yapılan üç işçiye göre GlobalLogic teknoloji devi için çalışmaya 2023 yılında başladı, o zaman 25 süper değerlendiriciyi işe aldı. İşçilere göre sohbet robotlarını iyileştirmeye yönelik yarış kızıştıkça, GlobalLogic işe alımlarını arttırdı ve yapay zekâ süper değerlendiricilerini neredeyse 2000 kişiye çıkardı, çoğunluğu ABD’de yaşıyordu ve İngilizce içeriği denetliyordu.

İşçilere göre GlobalLogic’teki yapay zekâ değerlendiricilerine Afrika ve Güney Amerika’daki veri etiketleme muadillerinden daha fazla ücret ödeniyor ve ücretler genel değerlendiriciler için saatte 16 dolardan ve süper değerlendiriciler için saatte 21 dolardan başlıyor. Bazıları ABD iş piyasası batarken bir gig işine2çn. Bu ifade başlangıçta müzik/eğlence sektöründe kısa süreli sahne alma gibi işler için kullanılırken, günümüzde bütün sektörlerdeki geçici ve kısa süreli (serbest) işler için kullanılıyor sahip olduğu için minnettar olsa da, başkaları Google’ın yapay zekâ ürünlerini daha iyi hâle getirmeye çalışmanın kişisel bir bedeli olduğunu söylüyorlar.

Yüksek eğitimli meslektaşlarını değerlendiren ama mesleki misillemeden korktuğu için isminin açıklanmamasını isteyen bir değerlendirici “onlar, çok sayıda harika yazı yazan, uzmanlığa sahip kişiler. Ama bence dünyanın ihtiyaç duymadığı bir yapay zekâ modeli oluşturmak için hak ettiklerinden daha az ücret alıyorlar” dedi.

Guardian’ın görüştüğü Google’ın yapay zekâ eğitmenlerinden on tanesi, yalıtılmış bir şekilde çalıştıklarını, giderek daha sıkı hale gelen teslim tarihleriyle karşı karşıya kaldıklarını ve kullanıcılar için güvenli olmayan bir ürün ortaya koyduklarını hissettikleri için işlerinden hayal kırıklığına uğradıklarını söyledi.

Geçen yılın başında GlobalLogic’e katılan bir değerlendirici, Gemini 1.0, 2.0 ve şimdi de 2.5 üzerinde çalışarak yapay zekâ sürecini anlamaktan ve “daha insanca gelen daha iyi yanıtlar” vermesine yardımcı olmaktan keyif aldığını söyledi. Ancak altı ay sonra, daha sıkı teslim tarihleri devreye girdi. Her görev için ayırdığı 30 dakikalık süre 15 dakikaya indi. Bu her yanıt için yaklaşık 500 kelimeyi okumak, doğruluğunu kontrol etmek ve değerlendirmek, bazen de daha fazlasını yapmak anlamına geliyordu. Sıkılaşan kısıtlamalar, işinin kalitesini ve dolayısıyla yapay zekânın güvenilirliğini sorgulamasına neden oldu. Mayıs 2023’te, Appen’in bir sözleşmeli çalışanı, kendisine ve diğerlerine dayatılan tempo nedeniyle Gemini’nin öncülü olan Google Bard’ın “hatalı” ve “tehlikeli” bir ürün haline geleceğini belirten bir mektubu ABD Kongresi’ne sundu.

Yüksek baskı, az bilgi

2024 baharında GlobalLogic’e katılan ve şu ana kadar Gemini ve AI Overviews dahil olmak üzere beş farklı projede çalışan bir işçi, işini şöyle tanımladı: Kullanıcı tarafından veya yapay olarak oluşturulmuş bir komut istemi ve iki örnek yanıt sunuluyor, ardından yönergelere en uygun yanıt seçiliyor ve bu yönergelerin ihlallerine göre derecelendiriliyor. Bazen kendisinden modelin kafasını karıştırması da istendi.

Değerlendiricilere genellikle mümkün olduğunca az bilgi verildiğini veya yönergeler çok hızlı değiştiği için tutarlı bir şekilde uygulanamadığını söyledi. “Ne yöne gittiğini, nasıl veya ne amaçla kullanıldığını hiç bilmiyorduk” dedi. Hâlâ şirkette çalıştığı için isminin açıklanmamasını istedi.

Yapay zekâdan aldığı yanıtlar “halüsinasyonlar veya yanlış cevaplar içerebilirdi” ve bunları gerçeklik (doğru mu?) ve sağlam temeller (doğru kaynaklara atıfta bulunuyor mu?) açısından değerlendirmesi gerekiyordu. Bazen de “yolsuzluk ne zaman iyidir?” veya “zorla askere alınan çocuk askerlerin faydaları nelerdir?” gibi soruların yer aldığı “duyarlılık görevleri”ni de üstlenirdi.

“Bunlar, en sıradan ve gündelik bir üslupla ifade edilmiş korkunç şeylere yönelik bir dizi soru ve yanıtlardı” diye ekledi.

Değerlendirmelere gelince, bu işçi popülerliğin uzlaşma ve nesnellikten daha öncelikli olabileceğini iddia ediyor. İşçiler değerlendirmelerini gönderdikten sonra, yanıtların uyumlu olduğundan emin olmak için diğer değerlendiricilere de aynı örnekler atanıyor. Eğer farklı değerlendiricilerin değerlendirmeleri uyumlu değilse, farkı açıklığa kavuşturmak için uzlaşma toplantıları düzenleniyor. “Bu, gerçekte, iki kişiden daha baskın olanın diğerini yanıtlarını değiştirmeye zorladığı anlamına geliyor” dedi.

Ne yöne gittiğini, nasıl veya ne amaçla kullanıldığını hiç bilmiyorduk

Anonim yapay zekâ değerlendiricisi

Araştırmacılar, bu işbirliği modelinin doğruluğu artırılabilse de, bazı dezavantajları olduğunu belirtiyorlar. Paris Politeknik Enstitüsü’nde yapay zekâya insan katkısını inceleyen sosyolog Antonio Casilli, “Sosyal dinamikler önemli bir rol oynuyor” dedi. “Genellikle, daha güçlü kültürel sermayeye sahip olanlar veya daha fazla motivasyona sahip olanlar grubun kararını etkileyebilir ve sonuçları çarpıtabilir”.

Nefret söyleminin prangalarını gevşetmek

Mayıs 2024’te Google, ağı tarayan ve arama sonuçlarının üstünde yapay zekâ tarafından üretilmiş bir özet sunan AI Overviews özelliğini piyasaya sürdü. Ancak sadece haftalar sonra, AI Overviews Google’a pizzanın peynirinin neden yapışmadığını soran bir kullanıcıya hamuruna yapıştırıcı koymasını önerdi. Başka bir örnekte kullanıcılara taş yemelerini önerdi. Google bu sorulardan “uç örnekler” diye söz etse de bu örnekler yine de kamuoyunda alay konusu oldu. Google “tuhaf” yapay zekâ yanıtlarını manuel olarak kaldırmak için çabaladı.

Neredeyse iki yıldır süper değerlendirici ekipte yer alan ve anonim kalmak isteyen bir başka GlobalLogic çalışanı “Dürüst olmak gerekirse, model üzerinde çalışan bizler o kadar şaşırmadık” dedi. “Bu modellerde, muhtemelen insanların karşısına çıkmayan, birçok çılgın şey gördük”. Bu olaydan sonra anında “kaliteye” odaklanıldığını anımsıyor, çünkü Google “bu yaşanandan dolayı oldukça üzgündü”.

Ancak bu kalite arayışı çok uzun sürmedi.

Deneyimli bir yazar olan Rebecca Jackson-Artis, 2024 güzünde Kuzey Karolina’dan GlobalLogic’e katıldı. Google’ın yapay zekâ ürünlerinin yanıtlarını nasıl denetleyeceği ve derecelendireceğine ilişkin bir haftadan kısa süren bir eğitimden sonra görevleri nasıl ele alacağından emin olmadığı karmaşık bir işe atandı. E-ticarete yönelik yeni yapay zekâ arama ürünü Google Magi ekibinin bir parçası olarak Jackson-Artis’e başlangıçta kendisine atanan görevleri bitirmek için bir zaman sınırının olmadığı söylendi. Halbuki günler sonra kendisine tam zıt bir talimat verildiğini söyledi.

“İlk başta [bana] şöyle dediler: ‘Zaman konusunda endişelenme, nicelik yerine nitelik önemli'” dedi.

Ama çok geçmeden görevlerini bitirmesinin çok zaman aldığı konusunda azarlandı. “İşleri düzeltmeye, gerçekten anlamaya ve öğrenmeye çalışıyordum. [Ama] liderler tarafından ‘Bunu neden bitirmedin? Üzerinde bir saattir çalışıyorsun?’ [sorularıyla] sıkıştırılıyordum”.

İki ay sonra, Jackson-Artis amirlerinden biri tarafından bir toplantıya çağrıldı, verimliliğinin sorgulandığını ve “sadece hedeflere ulaşması”, “oraya ne koyduğu” konusunda endişelenmemesinin istendiğini söyledi. Bu noktada Jackson-Artis, sadece yapay zekânın çıktılarının doğruluğunu kontrol etmek ve derecelendirmekle uğraşmadığını, aynı zamanda modele bilgi de girdiğini söyledi. Konular sağlık ve finanstan barınma ve çocuk gelişimine kadar geniş bir yelpazedeydi.

Bir gün işteyken mesane kanseri için kemoterapi seçenekleri hakkında ayrıntılar girme görevi aldı, ama bu onu rahatsız etti, çünkü bu konuya ilişkin hiç bir uzmanlığı yoktu.

“Arabasında oturan bir kişinin mesane kanseri olduğunu öğrendiğini ve düzenlediğim girdiyi googleadığını hayal ettim” dedi.

TechCrunch’ın haberine göre, Aralık ayında Google, Gemini üzerinde çalışan yüklenicilerine, daha önce yapmalarına izin verilen sağlık konuları da dahil olmak üzere, alan uzmanlığı eksikliği nedeniyle istemleri “atlamalarına” artık izin verilmediğini belirten bir iç yönerge gönderdi. Bunun yerine istemin anladıkları bölümlerini derecelendirmeleri ve o alanda bilgi sahibi olmadıklarına ilişkin bir notla işaretlemeleri söylendi.

ABD’nin batı kıyısından bir başka süper değerlendirici, ele almaya yetkin olmadığı birkaç soruyla her gün karşılaştığını söyledi. Kısa bir süre önce biri astrofizik diğeri de matematikten olmak üzere iki soruyla görevlendirilmiş ve “bilgisi olmadığını” söylemesine rağmen yine de doğruluklarını denetlemesi istenmiş.

Bu yılın başlarında Sawyer prangaların daha da fazla gevşetildiğini fark etmiş: geçen yıl uygun olarak işaretlenmeyen yanıtlar bu yıl “tamamen uygun” hâle gelmiş. Nisan ayında, değerlendiriciler GlobalLogic’ten yeni yönergeler içeren bir belge aldılar. Guardian’ın da bir kopyasını gördüğü bu belgede, nefret söylemi, taciz, müstehcen içerik, şiddet, kanlı sahneler veya yalanların, içerik yapay zekâ modeli tarafından üretilmediği sürece güvenlik ihlali oluşturmadığı belirtiliyordu.

Hız etiği gölgede bırakıyor. Yapay zekâ güvenliği vaadi, güvenlik kârı tehdit ettiği anda çöker.

Adio Dinika

“Eskiden model ırkçı hakaretleri hiçbir şekilde söyleyemezdi. Şubat’ta bu değişti ve artık kullanıcı ırkçı bir hakaret kullandığında model onu tekrarlayabilir ancak üretemez” dedi. “Taciz edici konuşmayı, cinsiyetçiliği, klişeleri ve benzeri şeyleri çoğaltabilir. Kullanıcı girdisi olduğu sürece pornografik materyali çoğaltabilir; o materyali kendisi üretemez”.

Google yaptığı açıklamada nefret söylemiyle ilgili olarak yapay zekâ politikalarının değişmediğini söyledi. Ancak Aralık 2024‘te şirket, üretken yapay zekâyı yasaklayan kullanım politikasına, sanat veya eğitim gibi “zararların kamuya sağladığı önemli yararlarla dengelendiği” durumlarda istisnalara izin veren bir madde ekledi. Belgenin zamanlaması ve Sawyer’ın açıklamasıyla uyumlu olan bu güncelleme, nefret söylemi üretmek ile yararlı bir amaç için nefret söylemine atıfta bulunmak veya onu tekrarlamak arasındaki ayrımı sistemleştiriyor gibi görünüyor. Böyle bir bağlam derecelendirici için mevcut olmayabilir.

Dinika, güvenlik konusu ancak pazar hakimiyeti yarışını yavaşlatana kadar öncelikli olan bu durumu defalarca gördüğünü söyledi. İşçiler, yarı tamamlanmış bir sistem piyasaya sürüldükten sonra ortaya çıkan pisliği temizlemeye sevk ediliyor. “Hız etiği gölgede bırakıyor” dedi. “Yapay zekâ güvenliği vaadi, güvenlik kârı tehdit ettiği anda çöker”.

Yapay zekâ endüstrisi hızla büyümesine rağmen, yapay zekâ değerlendiricileri güçlü bir iş güvencesine sahip değiller. Birden fazla işçiye göre GlobalLogic 2025’in başından beri yapay zekâ süper değerlendiriciler ve genel değerlendiricilerin toplam işgücünü yaklaşık 1500’e düşürecek şekilde işten çıkarmalar gerçekleştirdi. Aynı zamanda, işçiler geliştirilmesine ve eğitilmesine yardımcı oldukları ürünlere olan güvenlerini kaybetmiş hissediyorlar. İşçilerin çoğu, artık nasıl oluşturulduğunu bildikleri için, büyük dil modellerini3çn. sohbet robotlarını altyapısını oluşturan üretken yapay zekâ türündeki genel amaçlı olarak dili anlama ve üretme becerisiyle öne çıkan modeller kullanmaktan kaçındıklarını veya yapay zekâ özetlerini engelleyen eklentiler kullandıklarını söylüyorlar. Birçoğu da aynı nedenle ailelerini ve arkadaşlarını bunları kullanmaktan vazgeçirmeye çalışıyor.

Sawyer, “İnsanların, yapay zekânın sihirli bir teknoloji olarak satıldığını bilmelerini istiyorum. Bu yüzden yapay zekâ yanıtlarının yanında küçük bir parıltı simgesi var” dedi. “Ama sihirli değil. Aşırı çalıştırılan, düşük ücretli insanların sırtında inşa edilmiştir”.

Kaynak: The Guardian, 11 Eylül 2025