Yapay zekâ akıllanıyor mu yoksa sadece taklit yeteneği mi gelişiyor?

Geçen gün kendimi beklenmedik bir tartışmanın ortasında buldum. Büyük dil modellerinin (LLM1 çn. “Large Language Model”, Büyük Dil Modelleri çok büyük miktarda veri üzerinde önceden eğitilmiş çok büyük derin öğrenme modelleridir. Metinleri anlama ve üretme konusunda uzmanlaşmış özel bir üretken yapay zekâ türüdür.) yapay zekâyı hiç de temsil etmeyebileceğini, aksine, anti-zekâ olarak adlandırdığım oldukça kafa karıştırıcı bir şeyi temsil ettiğini öne sürdüm. Aptallık değil, zekânın tersi. Bu insan bilişinden salt farklı olmakla kalmayıp, ona zıt konumlanan bir sistem. Bir ayna değil, ama akıcı, ikna edici ve temel dayanaktan yoksun ve insanlığımızla hiçbir bağı olmayan bir tür bilişsel sahtelik.

Bu çerçeve sinirime dokunuyor. Çünkü bağdaşımı2çn. coherence. Tutarlılık, uyum, insicam anlamlarından daha iyi karşıladığı için teknik bir karşılık olarak bağdaşım tercih edilmiştir idrakla karıştırmaya başladık. Ve bu düşünme şeklimizi, karar verme yetimizi ve hatta zekâyı nasıl tanımladığımızı sessizce değiştiriyor.

Anti-zekâ Nedir?

Anti-zekâ bilmeme hâli değildir. Anlamadan bilme performansıdır. Hafızadan, bağlamdan veya niyetten ayrılmış dildir. Büyük dil modelleri aptal değildir, yapısal olarak kördür. Ne söylediklerini bilmiyorlar ve daha da önemlisi bir şey söylediklerini bilmiyorlar.

Geleneksel anlamda zekâ yoksunluğuna sahip değiller. Onlar algıya değil de tahmine dayanan tamamen farklı bir mimari üzerinde çalışıyorlar. Tekrar söylemekte yarar var, düşünce oluşturmuyorlar, düşünce desenleri eşleştiriyorlar.

Bu, insani bilişsel yeteneklerimize layık bir paradokstur. Zeki dediğimiz sistemler bilgi oluşturmuyor. Yargı, derinlemesine düşünme veya gerçeğe dayandırma gerektiren bir soru sorana (ya da belki de sistemde bir soruna yol açan basit bir ilgisiz sözle karşılaşana) kadar gerçek olandan ayırt edilemeyen bir bilgi görünümü oluşturuyorlar. Okumaya devam edin, ne demek istediğimi anlayacaksınız.

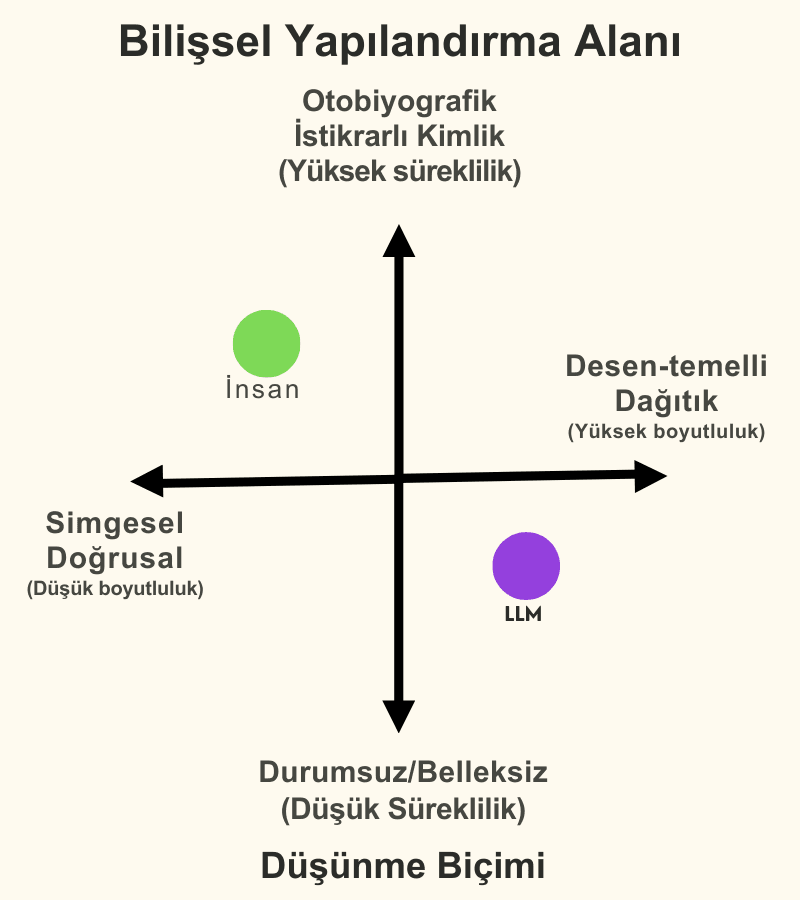

Görselleştirilmiş Bilişsel Ayrım

Farkı daha iyi anlamak için onu görsel olarak ifade edebiliriz diye düşündüm. Yapmaya çalıştığım, henüz erken bir aşamada olsa da, sadece performansı değil, düşünce yapılandırmasını da hesaba katan bir çerçeve oluşturmak.

Bir spektrum değil bir harita, insan ve makine bilişi temelde farklı çeyreklerde yer alıyor. Kaynak: ChatGPT, NostaLab tarafından değiştirilmiş

Sol üstte insan bilişini görüyoruz. Otobiyografik, simgesel ve büyük ölçüde doğrusal. Hatırlarız, gözden geçiririz, cümlelerle konuşuruz ve zamanla kimlikler oluştururuz.

Sağ altta büyük dil modeli. Durumsuz, dağıtık, yüksek boyutlu ve belleksizdir. “Benlik”i yoktur. Ancak bir konuda mükemmeldir, o da süreklilik olmadan bağdaşım sağlamaktır. Bir zihin değildir, ama anlamadığı desenlerin arayışındadır.

Tehlike, standart altı bir insan yaratmış olmamız değil. Bize benzeyen “yabancı” bir şey yapmış olmamız. Ve benzerliği arttıkça, ayrımı ortadan kaldırmak daha da cazip hale geliyor. Ve son tahlilde, en büyük endişem de bu.

Asimptot ve Yanılsama

Peki, yapay zekâ iyice gelişip insan bilişinden ayırt edilemeyecek bir hâle gelirse ne olur? Arayüz, ona riayet edeceğimiz, güveneceğimiz ve kabullenmeye başlayacağımız kadar ikna edici bir “zekâ sergilerse”, insanlığın “gidişat”ı ne olur?

Bu asimptotik yanılsamadır. Yapay zekâ zeki olmak zorunda değil. Rolünü oynaması yeterlidir. Ve bunu büyük ölçekte, hızlı bir şekilde ve tereddüt etmeden yapmalıdır. Simülasyon “yeterince iyi” hâle gelir ve işlev, temel bir şey gibi görünmeye başlar.

Şimdi sırada bazılarının “Ne olmuş yani?” diyeceği ilginç bir soru var. Eğer çalışırsa, nasıl çalıştığının bir önemi var mı? Elbette çeviri, özet çıkarma, kaba kuvvetle problem çözme gibi bazı alanlarda önemi olmayabilir. Ama başka alanlarda oldukça önemli olduğunu düşünüyorum. Yapay zekâ bir terapist, bir öğretmen veya bir doktor olarak konuştuğunda, performans ve mevcudiyet arasındaki ayrım artık akademik bir konu olmaktan çıkar, insan ilişkilerinin tam da merkezine yerleşir.

Ve bu noktada sadece çıktılarla uğraşmıyoruz. Hesap verebilirliği olmayan bir otoriteyle karşı karşıyayız. Ve bu yanılsama inanılacak kadar iyiyse, sonuçlar salt teknik olmayacaktır; psikolojik, epistemik ve hatta ahlaki açıdan da etkileri olacaktır.

Yeni bir araştırma bu riski görmezden gelmeyi daha da zorlaştırıyor. Araştırmacılar geçtiğimiz günlerde bir matematik problemine ilgisiz bir ifadenin (örn. “ilginç bir olgu: kediler yaşamlarının çoğunda uyuyor”) eklenmesinin LLM’lerin hata oranlarını üç katına çıkarabileceğini gösterdiler. Problemin özü değişmiyor, ama modelin çıktısı çöküyor. İnsanlar bu gibi gürültüleri görmezden gelirler, ancak LLM’ler onlarla başa çıkmakta zorlanıyorlar. Bu, akıcı çıktının ardında gizlenmiş “yapısal kırılganlığı” ortaya koyuyor. Dil anlaşılmadan üretildiğinde olabileceklerin bir örneğidir bu. Anti-zekânın görünür hâle gelmesidir.

Söylemin Farklı Bir Şekilde İfade Edilmesi

Unutmayalım, bunu “anti-zekâ” olarak adlandırmak bir reddiye değildir. Bence bu, kendimizden çok farklı ama güçlü bir şey yarattığımıza ilişkin açık bir uyarıdır. Aksini iddia etmeye devam ettiğimiz sürece, gerçek zekânın ne olduğunu kolayca gözden kaçırırız. Zekâ; zaman, hafıza, çelişki, gözden geçirme ve şüphe yoluyla anlam oluşturma yeteneğidir.

Ve işte eksik olan budur. Anti-zekâ olarak adlandırılmasının nedeni budur, yokluk değildir temelde bir şeyin tersine çevrilmesidir.

Peki Şimdi Ne Olacak?

Yeni bir bilişsel alana girmiş bulunuyoruz. Makine ile zihin arasında bir vadi değil, bir şekilde doldurulması gereken, bilme mimarisindeki bir çatlak. LLM’lerin bizi simüle etmesi, bize benzedikleri için değil. Bizi simüle ediyorlar; çünkü yazdıklarımızı, neden yazdığımızı anlamadan, yansıtmaları için eğittik.

Bu zekânın sonu değil. Ancak bu başka bir şeyin başlangıcı olabilir. Ve onu nasıl adlandırdığımız ve çerçevelendirdiğimiz, düşünen ile sadece öyle görünen arasındaki kırılgan, hayatî farkı koruyup korumayacağımızı belirleyebilir.

John Nosta, inovasyon teorisyeni ve NostaLab’ın kurucusudur.

Kaynak: Psychology Today, 8 Temmuz 2025